隨著企業數字化轉型的深入,數據已成為核心生產要素。大數據技術正以前所未有的速度與網絡技術深度融合,催生出邊緣計算、實時分析、智能運維等全新應用場景。對于希望投身于這一領域的工程師或學習者而言,一條清晰的學習路線至關重要。本文將為您規劃一條從網絡技術基礎出發,逐步深入大數據核心領域的系統性學習路徑。

第一階段:筑牢網絡技術基石

大數據系統本質上是構建在龐大、復雜的網絡之上的分布式系統。堅實的網絡技術基礎是理解其運行機制的起點。

1. 計算機網絡核心原理

- 重點掌握:深入理解TCP/IP協議棧(特別是TCP/UDP)、HTTP/HTTPS協議、DNS解析過程。這些是數據在網絡中傳輸的“通用語言”。

- 關鍵技能:學會使用Wireshark、tcpdump等工具進行網絡抓包與分析,能夠診斷常見的網絡連通性與性能問題。

2. 現代網絡架構與虛擬化

- 云計算網絡:理解VPC(虛擬私有云)、子網、路由表、安全組/ACL、負載均衡器等云網絡組件的概念與配置。熟悉AWS、阿里云或騰訊云等至少一家主流云廠商的網絡服務。

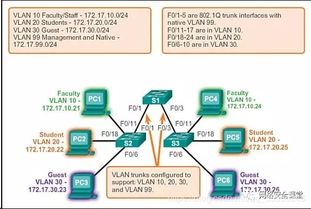

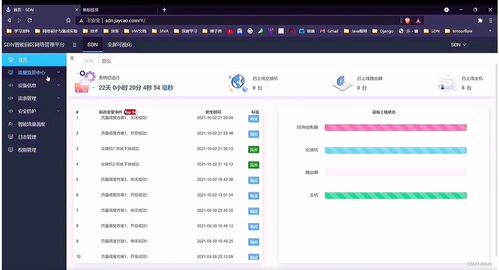

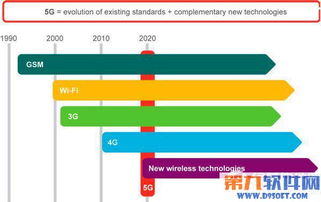

- 網絡虛擬化:了解SDN(軟件定義網絡)的基本思想,以及Overlay技術(如VXLAN)如何實現大規模、多租戶的網絡隔離與靈活組網。這對理解大數據集群(如Kubernetes集群)的網絡模型至關重要。

3. 網絡性能與安全

- 性能調優:理解帶寬、延遲、吞吐量、丟包率等關鍵指標,掌握基本的QoS(服務質量)概念。

- 安全基礎:熟悉防火墻、VPN、零信任網絡等基礎安全架構,了解大數據環境中數據在傳輸與靜止狀態下的加密需求。

第二階段:跨越到大數據的橋梁

此階段的目標是將網絡知識應用于分布式計算環境,理解數據如何被高效、可靠地移動和處理。

1. Linux操作系統與Shell編程

- 大數據生態幾乎全部構建在Linux之上。必須熟練使用Linux命令行,掌握進程管理、文件系統、網絡配置等技能。掌握Shell/Python腳本進行自動化運維。

2. 核心分布式系統概念

- 關鍵理論:理解CAP定理、一致性模型(強一致性、最終一致性)、分布式事務、共識算法(如Raft)的基本思想。

- 核心組件:學習ZooKeeper或Etcd,理解它們在分布式協調、服務發現、配置管理中的作用。

3. 大數據存儲基石:HDFS與對象存儲

- HDFS:深入學習Hadoop分布式文件系統的架構(NameNode, DataNode)、讀寫流程、容錯機制。理解其如何利用普通服務器構建高容錯的存儲池。

- 對象存儲:掌握如AWS S3、阿里云OSS等對象存儲的服務概念、API使用及與HDFS的異同。對象存儲已成為數據湖架構的事實標準。

第三階段:深入大數據處理核心

掌握了數據和網絡如何流動后,進入數據處理的核心層。

1. 批處理引擎:Apache Spark

- 作為當今最主流的批處理框架,重點學習Spark Core(RDD編程模型)、Spark SQL(結構化數據處理)、Spark運行架構(Driver, Executor)。思考其Stage劃分、Shuffle過程與網絡數據傳輸的密切關系。

2. 流處理引擎:Apache Flink / Apache Kafka Streams

- Flink:學習其流處理優先的架構、時間窗口、狀態管理、Exactly-Once語義。理解其如何通過網絡實現低延遲、高吞吐的數據流水線。

- 消息隊列:深入學習Apache Kafka,它不僅是消息隊列,更是流式數據的“中樞神經系統”。理解其Topic、Partition、Producer、Consumer模型,以及高吞吐背后的網絡優化(如零拷貝、批量發送)。

3. 資源管理與調度:YARN與Kubernetes

- YARN:理解其在Hadoop生態中的角色,如何統一管理集群資源(CPU、內存)。

- Kubernetes:作為云原生時代的事實標準,必須學習其Pod、Service、Ingress、NetworkPolicy等資源對象。理解Calico、Flannel等CNI插件如何為大數據應用提供網絡。學習在K8s上部署和運行Spark、Flink等應用。

第四階段:融合與實戰——構建數據流水線

將前面所有知識融會貫通,設計并實現端到端的數據系統。

1. 數據流水線架構設計

- 設計一個典型的數據平臺:從數據采集(通過日志收集、數據庫變更捕獲CDC)、通過網絡傳輸(經由Kafka)、到實時/批處理(Flink/Spark)、最終存儲與服務于應用(數據庫、數據倉庫、API)。

- 重點關注網絡考量:跨機房/云區域的數據同步帶寬與成本、流水線各組件間的網絡延遲與容錯、安全組與防火墻策略的配置。

2. 運維與監控

- 監控體系:運用Prometheus監控集群資源(網絡IO、帶寬使用率)及大數據組件指標(Kafka Lag、Spark Executor狀態)。使用Grafana進行可視化。

- 日志收集:使用ELK(Elasticsearch, Logstash, Kibana)或Loki堆棧集中管理分布式系統日志,便于故障排查。

3. 持續學習與前沿探索

- 云原生大數據:關注Serverless大數據服務(如AWS Glue、Google BigQuery)、以及Flink on K8s等云原生部署模式。

- 網絡新技術:關注eBPF技術在網絡可觀測性、安全過濾方面的應用,以及其對大數據監控能力的提升。

- 領域融合:探索AIOps(智能運維),利用大數據和機器學習算法來預測網絡故障、優化資源調度。

###

從網絡技術邁向大數據,并非轉行,而是視野的擴展與能力的疊加。這條路線強調理解數據在網絡中的“旅程”——從產生、流動、到被計算和消費。建議學習者遵循“理論 -> 單個組件 -> 系統集成 -> 實戰優化”的路徑,同時保持動手實踐:可以在本地使用虛擬機搭建Hadoop/Spark集群,或在云上利用免費額度進行實驗。堅實的網絡技術背景將成為您在大數據領域洞察系統瓶頸、設計高可用架構的獨特優勢,助您在數據洪流中架起穩固而高效的橋梁。